GPU集群网络集群规模集群算力gpu集群的情况如下GPU集群网络 网络配置GPU服务器间的网络配置对集群性能至关重要例如gpu集群,Nvidia DGX A100推荐的配置是200 Gbps卡,这一配置是由GPU卡的PCIe带宽决定的不同的GPU服务器型号,如A800和H800,其计算网络配置各异,以适应不同的需求 网络架构集群网络。

GPU集群软件是一种专门用于管理和优化多个GPU在集群环境中运行的软件解决方案其主要特点和功能包括核心功能提高计算效率和资源利用率在高性能计算和深度学习等应用中,通过将多个GPU组合成集群,可以大幅提升整体计算能力和效率任务调度GPU集群软件负责调度任务,确保每个GPU都能处理最适合自己的工作。

首个国产全功能GPU的万卡集群已经由“中国版英伟达”摩尔线程正式发布以下是关于该万卡集群的详细解答算力强大该万卡集群的算力超过万P,专为训练万亿参数级别的复杂大模型而设计夸娥万卡集群的超大算力达到10ExaFlops,显存容量和卡间互联总带宽均达到PB级,实现了算力显存和带宽的系统性协同优化。

小作坊实验室的简易 GPU 集群使用心得集群管理与部署直接连接方式对于小作坊式的科研工作,采用直接连接服务器的方式可能更为灵活,可以绕过主节点,实现程序的快速部署和运行管理软件选择虽然Sun Grid Engine等集群管理软件在大型集群中常用,但对于频繁微调程序的场景,直接连接方式可能更为适合。

英伟达平替方面,国产GPU万卡集群,如摩尔线程的夸娥智算集群,已成为一个有力的选择以下是关于国产GPU万卡集群作为英伟达平替的详细解答1 算力强大** 摩尔线程的夸娥智算集群实现了从千卡到万卡的飞跃,为大模型训练提供了强大的算力支持在AI大模型时代,算力需求激增,夸娥智算集群能够满足这。

海外大厂如OpenAI谷歌Meta等已部署数万张高端GPU进行大规模训练,而国内云大厂如华为科大讯飞天翼云中国移动等也已纷纷建设万卡级算力平台然而,基于国产GPU的万卡方案尚属新颖昨日,摩尔线程宣布其夸娥智算集群解决方案实现重大升级,从千卡扩展至万卡规模,这标志着国产GPU技术的新里程碑该。

摩尔线程发布的“夸娥万卡智算集群”是国产GPU万卡集群的一个具体解决方案该集群通过优化分布式并行计算高效显存管理和超长序列训练等技术,实现了万卡以上规模的有效计算,且计算效率达到国际标准的60%,稳定性超过99%应用通用性夸娥集群不仅关注大模型的规模,还强调其通用性,支持AI在物理仿真3D。

总之,GPU集群软件不仅仅是一种技术集合,它是一种革新性的计算模式,通过整合GPU的威力,为现代科技发展提供了强大的动力如果gpu集群你想探索这个领域的更多可能,不妨考虑寻求像思腾合力这样的专业机构,gpu集群他们将为gpu集群你揭开GPU集群的神秘面纱,带你领略计算效率的惊人提升。

GPU集群的算力可以用公式Q = C*N*u来衡量,其中C是单卡峰值算力,N是GPU数量,u是算力利用率算力利用率和线性加速比k一起描述集群性能,理想情况下,随着GPU数量增加,算力线性增长,但实际效率受多种因素影响,一般线性加速比在90%以上,大规模集群的算力利用率通常在50%左右。

MFUModel FLOPS Utilization统计方法用于评估算力利用率,其计算公式为平均训练FLOPS除以卡的峰值FLOPS例如,MegaScale论文中提到,对于千卡集群,算力利用率约为59%万卡集群下,这一比例降低至552%GPU集群线性加速比反映了随着GPU数量增加,计算任务完成速度提升的比例与GPU卡数量增加的比例之间的。

张高性能GPU,算力超万P,专为复杂大模型训练设计其规模与性能,不仅在于万卡万P的超大算力,还体现在有效计算效率MFU最高可达60%,显存容量达到PB级,卡间互联总带宽和节点互联总带宽同样达到PB级。

在AI时代的GPU集群网络算力分析中,首要关注点是GPU集群的有效算力单个GPU卡的有效算力可通过其峰值算力来估算,例如,Nvidia A100的峰值FP16BF16稠密算力为312 TFLOPS,实际有效算力约为298 TFLOPSGPU集群的规模和总有效算力取决于集群网络配置与使用的交换机设备Nvidia提供推荐配置,例如DGX A100服务。

GPU集群顾名思义就会一堆GPU机器通过软件集成到一起,主要用来做大数据计算的gpu。

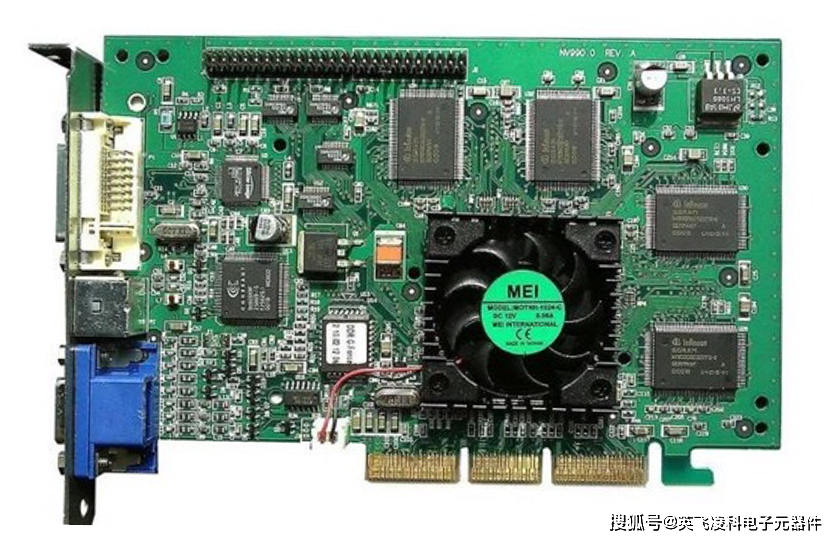

高性能GPU服务器硬件拓扑与集群组网,采用集群式架构,每台主机配备8块高性能GPU,包括A100A800H100H800四种机型典型8*A100GPU主机内部硬件架构包括高效互联的PCIe总线NVLinkDCGM监视工具NVSwitch交换芯片等PCIe技术提供高效数据传输,支持设备如CPU内存NVMEGPU和网卡通过PCIe总线互联。

AntMan Dynamic Scaling on GPU Clusters for Deep Learning是一篇针对深度学习领域中GPU集群资源使用率低问题提出解决方案的论文以下是关于该论文内容的详细解答问题背景论文揭示了GPU集群资源使用率低的两大原因任务抢占导致的资源分配不合理,以及多张GPU执行任务时的等待时间过长现有解决方案的。

GPU集群软件是一个计算机集群,其中每个节点配备有图形处理单元通过图形处理单元上的通用计算来利用现在GPU的计算能力,可以使用GPU集群执行非常快速的计算说起来还挺复杂,建议你要是想了解还是去专业的厂商去了解会更加清楚一点,思腾合力是英伟达的代理商,在这个方面做的还挺不错的,你可以去了解下。

近日,摩尔线程发布了其国产GPU万卡集群解决方案“夸娥万卡智算集群”,标志着国产GPU正式迈入万卡时代从千卡到万卡,这一跨越涉及复杂的技术难题,如如何实现高密度的算存高性能网络连接和高效并行计算夸娥万卡集群通过优化分布式并行计算高效显存管理和超长序列训练,以及软硬件全栈的优化,实现。

展示了包括计算加速卡服务器超融合一体机万卡集群方案和AIGC应用在内的摩尔线程全栈AI产品,以及与众多行业合作伙伴共同展示的基于夸娥智算集群的丰富行业大模型与应用方案摩尔线程在成立仅三年半的时间内,建立了从芯片加速卡服务器集群到软件的全栈AI智算产品线其中,全功能GPU芯片采用。

上一篇: 移动互联网技术,移动互联网技术专业

微信医疗(登记+咨询+回访)预约管理系统

微信医疗(登记+咨询+回访)预约管理系统  云约CRM微信小程序APP系统定制开发

云约CRM微信小程序APP系统定制开发  云约CRM体检自定义出号预约管理系统

云约CRM体检自定义出号预约管理系统  云约CRM云诊所系统,云门诊,医疗预约音视频在线问诊预约系统

云约CRM云诊所系统,云门诊,医疗预约音视频在线问诊预约系统  云约CRM新版美容微信预约系统门店版_门店预约管理系统

云约CRM新版美容微信预约系统门店版_门店预约管理系统 云约CRM最新ThinkPHP6通用行业的预约小程序(诊所挂号)系统

云约CRM最新ThinkPHP6通用行业的预约小程序(诊所挂号)系统联系电话:18300931024

在线QQ客服:616139763

官方微信:18300931024

官方邮箱: 616139763@qq.com